Ética y algoritmos en un mundo «inteligente»

Sí, los algoritmos, el «software inteligente» y demás, están aquí para quedarse, y esa es una realidad que tendremos que aceptar algún día porque cuanto más tiempo pase, más nos encontraremos en la intersección de la humanidad y la tecnología en un choque. de ética y necesidades que resolver, con todos los aspectos de nuestras vidas estrechamente relacionados con la tecnología de formas que ni siquiera entendemos.

Los humanos como especie hemos vinculado nuestra evolución a la tecnología, y eso está bien; pero los esfuerzos más recientes han sido sesgados porque no estábamos prestando atención a algunos aspectos invisibles de la tecnología y las relaciones de las personas con ella, y eso nos va a morder.

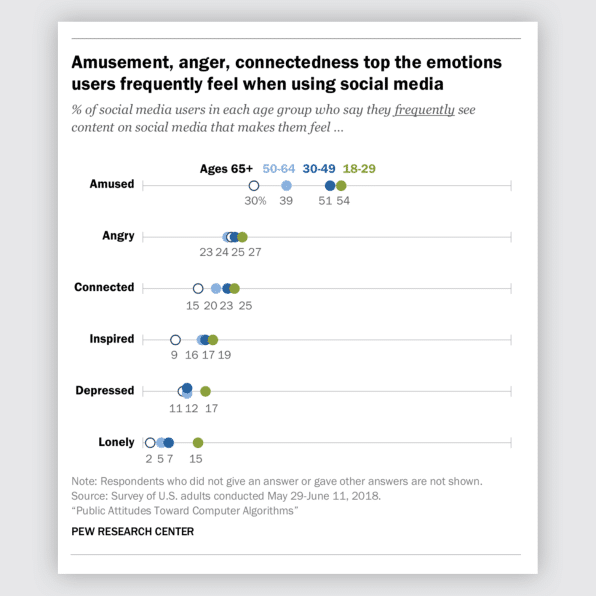

En un estudio reciente por el Pew Research Center con más de 4.000 personas, descubrieron cómo se sienten las personas acerca de los algoritmos que toman decisiones en la sociedad, y notan que las personas sienten «amplias preocupaciones sobre la equidad y la eficacia de los programas de computadora que toman decisiones importantes en la vida de las personas«, lo que demuestra que las dos emociones más frecuentes informan que los sentimientos son diversión y enojo.

Algo que ya se evidenció en un estudio previo de 7000 historias del New York Times, reveló que los artículos que inducen ira o ansiedad son más propensos a estar en la lista más enviada por correo electrónico, y algo que también se encuentra en otro estudio en más de medio millón de tweets sobre temas políticos donde los investigadores encontraron que los tweets «que incluyen lenguaje moral y emocional tienen más probabilidades de extenderse dentro de las redes ideológicas del remitente».

La ética como un trabajo en progreso.

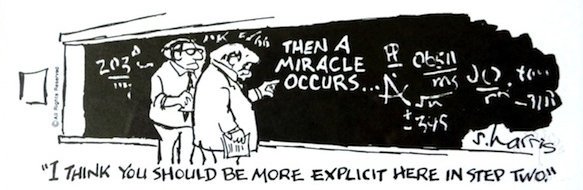

Algunas de estas «conexiones» son francamente amenazantes. Los desarrollos en campos previamente desarticulados, como la inteligencia artificial (IA), el aprendizaje automático, la robótica, la nanotecnología, la impresión 3D y la genética y la biotecnología, causarán una interrupción generalizada no solo a los modelos de negocio sino también a los mercados laborales durante los próximos cinco años, que en el tiempo provoca enormes niveles de ansiedad y desconfianza por parte de la opinión pública, no solo en la tecnología, sino también en las personas que la crean, y en algunos casos con razón; hay una gran preocupación por el sesgo y la injusticia infundido en algoritmos, a veces porque incluso aquellos que crearon el código ni siquiera saben cómo hace lo que hace.

Nosotros, las personas que creamos este futuro, somos los que tenemos la mayor responsabilidad aquí, porque somos los que decidimos quién tiene que tomar la culpabilidad cuando nuestros algoritmos fallan y cómo la tecnología que creamos impacta la vida de las personas, una tarea desalentadora porque los problemas éticos involucrados en la gestión y el desarrollo de la tecnología de la información son muchos, y se ven cada vez más complicados por el poder de las personas y las infraestructuras. Existen múltiples esfuerzos para mirar esta nueva problemática, pero no hay un conjunto completo de estándares que incluya a toda la industria. Quizás sea porque, como Yonatan Zunger escribe en el Boston Globe, “… el campo de la informática, a diferencia de otras ciencias, aún no ha enfrentado serias consecuencias negativas por el trabajo que realizan sus profesionales..”

¿Hay alguna manera de involucrar a la ética en los algoritmos?

Sé que puede ser difícil saber dónde existe la línea entre lo correcto y lo incorrecto en nuestro contexto, aún más cuando lo estamos caminando, lo que lo hace más difícil porque ya estamos sesgados hacia nuestro trabajo, pero entendemos los principios éticos, estar alerta y mantenernos humanos al respecto es el punto de partida de un viaje realmente largo, uno que quiero emprender.